Reconnaissance faciale et libertés individuelles, où est la limite ?

Titre : La reconnaissance faciale et libertés individuelles, où est la limite ?

Intervenant·e·s : Asma Mhalla - François Bersani - Stéphanie De Muru

Lieu : L'Info - Le face-à-face - RT France

Date : novembre 2019

Durée : 23 min 23

Visualiser l'émission

Licence de la transcription : Verbatim

Illustration : capture d'écran de la vidéo

NB : transcription réalisée par nos soins, fidèle aux propos des intervenant·e·s mais rendant le discours fluide.

Les positions exprimées sont celles des personnes qui interviennent et ne rejoignent pas nécessairement celles de l'April, qui ne sera en aucun cas tenue responsable de leurs propos.

Transcription

Stéphanie De Muru : Pour en débattre nous sommes avec Asma Mhalla spécialiste des enjeux économiques numérique. Bonsoir, merci d’être en direct avec nous sur RT France. À ses côtés François Bersani, secrétaire départemental Unité SGP Police.

Tout d’abord, Asma Mhalla, ce débat que souhaite la CNIL arrive un petit peu tard peut-être. On sait que la reconnaissance faciale est déjà testée dans plusieurs régions de France et qu’elle va se mettre en place inéluctablement. Est-ce que ce n’est pas un faux débat, finalement aujourd’hui, ou qui arrive un peu tard ?

Asma Mhalla : D’une part, en fait, il n’est jamais trop tard et mieux vaut tard que jamais. Le rapport1 qu’a rendu la CNIL est fondamental et très important parce qu’il commence à poser les premiers termes du débat et une forme de méthodologie justement, un cadre légal et potentiellement éthique, donc de ce point de vue il est forcément bienvenu. La question qui est fondamentale dans le rapport que la CNIL rend en réalité c’est la question des usages. Ce qui pose souvent problème c’est l’introduction des usages de la reconnaissance faciale d’abord par des usages marketing et commerciaux, donc une banalisation, une accoutumance à ces usages-là pour, progressivement, les amener en réalité sur le terrain sécuritaire de la police et de la surveillance généralisée. Donc c’est ce risque fondamental qu’on doit tous préempter autour non pas d’un débat public mais vraiment d’un débat qui est beaucoup plus démocratique et beaucoup plus éclairé que ce qu’on voit aujourd’hui apparaître. En ce sens, la CNIL envoie un signal qui est plutôt fort et plutôt positif.

Stéphanie De Muru : François Bersani, vous étiez visés, les policiers. On imagine que vous, en tant que policier, vous vous réjouissez plutôt de ce nouvel outil qui peut peut-être même, je n’en sais rien, faire des miracles dans vos enquêtes ?

François Bersani : Tout à fait Stéphanie. Pour nous c’est un vrai outil d’aide à l’enquête, un outil d’élucidation pour les forces de police, police-gendarmerie, donc toutes les forces de sécurité qui ont à traiter de la lutte par exemple contre le terrorisme mais aussi sur le contrôle des flux migratoires ou l’élucidation de crimes et délits. Jusqu’à présent nous traitions beaucoup avec la vidéoprotection, avec les images vidéo, voire des images à l’ancienne, mais il est aujourd’hui utile pour une police du 21e siècle d’utiliser des nouveaux arsenaux, un nouvel arsenal dont la reconnaissance faciale qui nous aurait grandement aidée, en tout cas tous les services d’enquête, lors des périodes par exemple des attentats ou même sur l’élucidation de crimes et délits. Donc ce n’est pas du tout une vision de flicage de la population ou de surveillance généralisée de la population, mais c’est bel et bien un outil très technique qui permet de faire avancer les enquêtes et de protéger aussi les biens et les personnes en pouvant très rapidement identifier des personnes recherchées puisque c’est le principal objectif.

Il faut savoir que pour une reconnaissance faciale il faut partir d’une base, il faut partir d’une base de données et sur les expérimentations qui ont été faites en France jusqu’à présent, on s’appuie très souvent sur le fichier des personnes recherchées. L’intérêt serait, par exemple dans les moyens de transport, de pouvoir identifier très rapidement des personnes qui sont actuellement recherchées au fichier des personnes recherchées aussi bien pour des faits de terrorisme que des faits de grande criminalité ou de grande délinquance. Il n’est pas question de surveiller nos voisins ou de se livrer à un flicage de la population entière.

Stéphanie De Muru : Votre voisine n’est pas du tout cas d’accord. C’est vrai, Asma Mhalla, vu comme ça, ça a l’air sympathique finalement on se dit « tiens !», à première vue.

Asma Mhalla : Il y a deux points dans ce que vous dites qui m’interpellent un tout petit peu c’est la question de l’efficacité : avoir un nouvel arsenal, oui, bien sûr. Mais en réalité, quand on regarde les risques encourus, ils sont fondamentaux. Scotland Yard, enfin Londres en fait, qui a été une des villes qui a déployé le plus massivement.

Stéphanie De Muru : Plus que Pékin d’ailleurs, c’est intéressant de le préciser parce qu’on s’imagine toujours que les Chinois sont…

Asma Mhalla : Absolument. C’est pour ça que j’évacue tout de suite l’exemple chinois qui est la dystopie absolue.

Stéphanie De Muru : Typiquement on en parle tout le temps, mais Londres est le grand utilisateur.

Asma Mhalla : Londres, en fait, est en Europe la ville qui déploie le plus massivement ce type de technologie et Scotland Yard, outre les ratés du carnaval de Notting Hill, etc., a diligenté une enquête qui montre qu’en réalité les logiciels de reconnaissance faciale se trompent à 80 %, en tout cas le taux d’erreur était de 80 % ce qui est absolument énormissime. Par ailleurs, même si on prend aujourd’hui les taux de fiabilité affichés par les Amazon, les Facebook, IBM, etc., qui sont un peu les meilleurs de la classe, les best in class sur ce type de techno, en réalité on a des taux d’erreur entre 2 et 3 %. 2 % ou 3 % sur 65 millions de Français, ça fait deux millions de Français potentiellement qui pourraient faire l’objet d’une erreur de reconnaissance du logiciel ou de l’IA qui est intégrée dans les dispositifs de caméras de vidéosurveillance. Donc il y a cette première question qui est la question de la fiabilité. Même un taux d’erreur qui est extrêmement faible peut potentiellement toucher une large portion de la population.

En second point, il y a aussi la question des biais. Qu’est-ce que c’est que la reconnaissance faciale ? C’est un algorithme qui est injecté dans des infrastructures de caméras de vidéosurveillance. Aujourd’hui, pareil, un certain nombre d’études montre que pour reconnaître des hommes blancs les taux de succès sont très importants. Quand il s’agit de reconnaître des femmes ou des personnes de couleur et à fortiori des femmes noires, on a des taux d’erreur qui peuvent monter à 35 %.

Stéphanie De Muru : Je vous arrête pour bien qu’on comprenne, tout simplement pour une question de technique, ça ne fonctionne pas bien ?

Asma Mhalla : Pour une question qu’en réalité, et c’est ce qui va me permettre de rebondir sur le dernier point, c’est la question des bases de comparaison. Un algorithme doit être entraîné, il va être alimenté dans son « éducation », entre guillemets, sur la base de comparaisons qui aujourd’hui sont essentiellement alimentées sur des hommes blancs. Donc quand on est femme ou quand on est de couleur, l’algorithme n’étant pas aussi bien entraîné, on a des taux d’erreur qui peuvent monter très haut. En réalité, le risque qu‘on encoure, réel, au-delà de toute analyse politique, c’est la question de la reproduction d’un certain nombre de discriminations.

Et sur la question des bases de comparaison, on a le TAJ [fichier de traitement des antécédents judiciaires], etc., mais en réalité, ce qu’on oublie souvent et c’est par petites briques qu’on voit, en fait, le système politique de la surveillance se déployer, c’est qu’il y a un an le fichier TES [fichier des titres électroniques sécurisés] a été validé, qui est la mégabase, le mégafichier de consolidation de l’ensemble des données des Français. Donc on a toutes les données classiques mais, en plus, on intègre des données biométriques : les photos quand elles sont là, les empreintes, etc.

Stéphanie De Muru : On le fait déjà d’ailleurs, les passeports, voilà.

François Bersani : Dans les aéroports avec le système PARAFE [passage automatisé rapide aux frontières extérieures] par exemple, qui est le passage automatisé maintenant rapide aux frontières extérieures. Ce sont ces portails qui vous permettent maintenant de gagner beaucoup de temps lors du franchissement de ces seuils d’enregistrement dans les aéroports. Nous nous rappelons, lorsqu’on a parlé au tout départ des passeports biométriques, on a crié au loup en se plaignant que ça allait être une intrusion terrible dans la vie privée des gens en créant ce passeport biométrique ou en installant ces systèmes de portiques PARAFE. En fait, on s’aperçoit qu’à l’épreuve des faits on a très peu de remontées négatives des titulaires de passeports biométriques ou des personnes qui empruntent ces portails PARAFE et qu'ils sont vraiment une fluidification inespérée lors des passages aux frontières.

Pour rebondir également sur ce que disait Madame Mallah il est vrai que si l’ADN est la chose la plus sure au niveau fiabilité, on a aussi connu des gens qui ont poussé des cris d’orfraie lorsqu’on a créé le FNAEG, le Fichier national des empreintes génétiques, on criait également au flicage, mais on s’est aperçu que c’est un instrument très fiable.

Il est vrai que le fichier automatisé des empreintes décadactylaires comme la reconnaissance faciale est également une marge d’erreur, mais les services de police sont d’abord très contrôlés. L’utilisation de tout ce qui est données privées, que ce soit avec la vidéoprotection en ville où ce genre de système-là est également très contrôlé et on sait que la France est un pays certes de liberté, mais avec énormément de gardes-fous. C’est-à-dire qu’on sait très bien que tout nouveau texte législatif qui va promouvoir, par exemple, un nouveau système intrusif va être déféré devant le Conseil d’État, le Conseil constitutionnel. Il y a également des autorités indépendantes comme la CNIL ou d’autres autorités de contrôle. C’est pour ça qu’il n’y a pas de craintes à avoir. Moi je ne suis pas dans le complotisme. On regarde aussi beaucoup de films et de romans sur les risques de captation des données. Il faut quand même rester dans le littéraire et dans le film, pour l’instant en France on en est très loin.

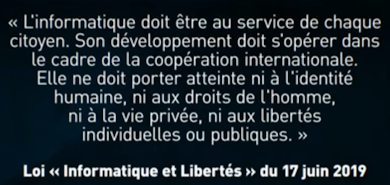

Stéphanie De Muru : Minoritory Report. Avant de poursuivre ce débat, pardonnez-moi je vous coupe, on va faire un petit point sur ce que dit la loi, la CNIL qui a donc rendu son rapport sur cette reconnaissance faciale, une technique qu’elle soutient mais à certaines conditions. Voici, en substance, ce qu’elle dit :

Voix off : « L’informatique doit être au service de chaque citoyen. Son développement doit s’opérer dans le cadre de la coopération internationale. Elle ne doit porter atteinte ni à l’identité humaine, ni aux droits de l’homme, ni à la vie privée, ni aux libertés individuelles ou publiques. »

Stéphanie De Muru : Est-ce que c’est un vœu pieux, « ni aux droits de l’homme, ni à la vie privée » ? Asma Mhalla, vous en pensez quoi ?

Asma Mhalla : Juste pour rebondir sur la question de la loi.

Stéphanie De Muru : On est dans le même thème.

Asma Mhalla : Absolument, ça répondra aussi à la question. La question de la loi n’est pas un garde-fou absolu et immuable. La loi, par définition, est un produit de l’homme, est un produit de l’histoire. Elle est constitutive de ce qu’on appelle l’État de droit, donc, en réalité, elle est parfaitement modifiable. D’ailleurs on le voit dans le fichier. Pour revenir juste sur le fichier TES, son article 4 est très intéressant parce qu’il va, en fait, dans votre sens et aussi dans l’intérêt de la police. Il dit que cette base de données bien que sacrée, bien qu’on puisse mettre autour tout un ensemble de gardes-fous, en réalité les agents y ont parfaitement accès dans les cas d’atteinte à l’intérêt suprême de la nation ou dans les cas de lutte antiterroriste. Or, qu’est-ce que c’est qu’un terroriste ? Et qu’est-ce que sera un terroriste demain ? Donc même les textes de loi qui sont aujourd’hui supposés être des gardes-fous sont, en réalité, aussi l’objet de l’arbitraire de l’interprétation du texte de loi. Et si demain on déploie cet arsenal dont vous dites avoir besoin, si on le met entre les mains d’un pouvoir un tout petit peu moins bienveillant, qu’est-ce que ça donne ?

Moi, ce qui m’inquiète beaucoup, c’est ce glissement invisible de ces technologies-là. En réalité elles sont intangibles, souvent le risque est aujourd’hui, vous l’avez dit en fait, hypothétique, donc en effet ne va pas générer une émotion plus que nécessaire, donc comment est-ce qu’on met proprement les termes du débat qui sont le risque de cette surveillance généralisée, mais qui ne se dit pas parce qu’elle est invisible et intangible.

Stéphanie De Muru : Justement, quels sont concrètement les risques que vous-même, en tant que policier, vous y voyez ? Vous nous avez bien expliqué les avantages, mais est-ce que vous y voyez, en toute honnêteté, aussi quelques risques, notamment pour nos libertés individuelles ?

François Bersani : Non, pas vraiment parce qu’on sait que la France est en train, un petit peu, de verser dans l’hygiénisme et dans le principe de précaution pour tout et on a tendance, en effet, à s’inquiéter de tous les défauts ou de tous les vices qui peuvent éventuellement survenir.

Je ne dis pas qu’il ne faut pas prendre des mesures de précaution. C’est bien pour ça que tout nouveau fichier dans la police nationale ou la gendarmerie nationale, tout nouveau système intrusif dans la vie privée est toujours bordé de gardes-fous. On est dans un pays des droits de l’homme, on a énormément d’instances qui veillent, justement, sur les garanties et les libertés individuelles, donc je ne suis pas plus inquiet que ça.

Après il faut connaître les enjeux : est-ce qu’on modernise les outils à la disposition des services de police, de gendarmerie, de contre-espionnage ou de sécurité intérieure et on accepte, en effet, qu’il existe des outils qui soient légèrement intrusifs. Mais c’est vrai que nous on est toujours amusés dans les services d’enquête quand les personnes que l’on reçoit se plaignent d’un risque sur la vidéoprotection ou sur les fichiers, parce que très souvent ces personnes qui se plaignent ce sont les premières à s’épancher sur les réseaux sociaux, sur Instagram, sur Snapchat, à raconter leur vie sur Facebook. Très souvent la population court plus de dangers dans sa vie privée à se livrer sans aucune limite, sans aucune barrière, en postant les photos du petit, de la grande, etc., en racontant ce qu’elle a fait hier, ce qu’elle fera demain. Et je peux vous rassurer, Stéphanie, bizarrement les services de police parfois sont beaucoup moins dotés d’outils que l’on peut croire et il y a encore toute une romance sur le méchant chinois, le méchant américain, le méchant russe ou le méchant de je ne sais quel pays qui viendrait espionner, capter des données. On ne sait pas ce qui sera dans 10, 20, 30, 40 ans, mais il est vrai que la police a besoin de se moderniser. La police française est quand même une des polices qui utilise le moins les technologies par rapport aux Anglo-saxons et on est très loin du Big Brother.

Stéphanie De Muru : Asma Mhalla, qu’est-ce que vous répondez à François Bersani ? D’ailleurs est-ce qu’on a un retour d’expérience de nos amis anglais qui utilisent justement ces techniques ? Est-ce qu’il y a eu des abus, des cas caractérisés d’atteinte à la liberté individuelle, à la vie privée ?

Asma Mhalla : À brûle-pourpoint est-ce que les Anglo-saxons sont sur le chemin du succès ou l‘exemple à suivre, je n’en suis pas certaine. J’en suis d’autant moins certaine que San Francisco a interdit la reconnaissance faciale à usage sécuritaire et policier. Ça montre bien, en réalité, que c’est en train de bouger et qu’on est un peu en train de revenir de cette béatitude face à la technologie et à l’innovation.

Ce qui est très inquiétant dans la tendance que prend la France c’est qu’on commence à expérimenter un certain nombre de choses, beaucoup de choses, et que le débat public tel qu’il nous est vendu en réalité n’arrive réellement jamais, qu’il soit éclairé, qu’il soit fondamentalement démocratique. Même récemment on a vu Cédric O, le secrétaire d’État chargé du numérique, appeler de ses vœux un débat public tout en permettant des expérimentations. Pourquoi ? Pour l’innovation. De qui ? Des industriels. Donc en réalité, l’impératif économique prévaut visiblement au débat démocratique librement ou totalement éclairé.

Stéphanie De Muru : Là on est plutôt dans le sécuritaire. Ce n’est pas plutôt le sécuritaire qui l’emporte ?

Asma Mhalla : Le sécuritaire l’emporte d’autant plus que depuis de nombreuses années, en France et dans les démocraties occidentales au sens large, on est sur une rhétorique politique de la sécurité, de l’ultra-sécurité, sur l’antagonisme, la peur, la menace, peu importe en réalité l’objet.

Stéphanie De Muru : Il y a quand même eu des attentats très meurtriers à Paris récemment.

Asma Mhalla : Absolument. Moi, ce qui m’inquiète un peu c’est qu’en fait, si on additionne la banalisation des usages d’une reconnaissance faciale ou d’une technologie qui est invisible, donc qu’on ne voit pas, c’est-à-dire qu’elle ne permet pas de matérialiser les risques – d’ailleurs vous parlez de gardes-fous. En réalité, sur les taux d’erreur potentiels, quels sont les recours administratifs ? Aujourd’hui il n’y en pas, il y a vide là-dessus : l’auditabilité des algorithmes, les biais qui sont incorporés dans les algorithmes. En réalité on est sur un no man’s land concret, en termes de gardes-fous concrets, sur cette question-là.

François Bersani : Je vous répondrai après.

Asma Mhalla : Merci. Par ailleurs il y a la banalisation des usages, il y a le discours général autour de la sécurité : le président a parlé récemment de la société de vigilance qui est potentiellement, en fait, une première brique. Quand on voit le TES, l’Alicem [Authentification en ligne certifiée sur mobile], la reconnaissance faciale à usage sécuritaire ou policier, l’ambiance générale qui donne un peu le ton de ce qui est en train de se jouer, le risque d’arriver à quelque chose qui n’est pas dystopique mais qui peut être une réalité très compliquée, c’est-à-dire lever l’anonymat dans l’espace public et donc atteindre forcément et fatalement à des libertés individuelles et fondamentales, qui sont la liberté d’expression, qui sont la liberté de manifester, qui sont le droit à la vie privée, parce qu’est-ce qui est plus privé que vos données biométriques, c’est-à-dire vos empreintes ou votre visage ? J’ai envie de vous dire pas grand-chose.

La société d’exposition dont vous parlez sur les réseaux sociaux en réalité elles sont captées derrière par qui ? Par les méta-plateformes, par les GAFA, etc. Donc on a un truchement, on a une hybridation privée-publique est pour le moins inquiétante.

François Bersani : Un des gardes-fous principaux en France c’est que les services de police ou de gendarmerie ou de sécurité intérieure n’utilisent pas ces fichiers ou ces nouvelles technologies comme l’alfa et l’oméga. C’est-à-dire que derrière chaque fichier ou derrière chaque exploitation de vidéoprotection il y a un homme. C'est-à-dire que même s’il y a éventuellement un défaut il est tout de suite corrigé puisqu’en fait on ne laisse pas, en France, la main aux machines, au hardware, donc il y a toujours un contrôle permanent.

Sur la vidéoprotection qui est maintenant déployée depuis beaucoup d’années dans les villes françaises, il y a eu tout un encadrement juridique en matière de conservation des données, d’effacement des données, par exemple des caméras de voie publique ne peuvent pas filmer ce qui se passe dans les bâtiments, il y a un système de floutage automatique qui se met en place. Donc je voudrais rassurer vos téléspectateurs pour ne pas être trop anxiogène. Il ne faut pas croire qu’aujourd’hui, en France en tout cas, il y a un espionnage mis en place en tout cas par les services de police. L’espionnage est dans votre carte de fidélité quand vous allez faire des courses dans les magasins, il est sur les cookies que vous laissez sur vos ordinateurs privés, il est sur les réseaux sociaux et il y a beaucoup plus de dangers, Asma je vous rassure, actuellement dans la sphère privée que du fait des forces de sécurité. Après c’est un choix : soit on travaille à l’ancienne avec la photo argentique, soit on essaye de moderniser mais tout en laissant, bien sûr, tout le temps un contrôle de l’autorité de l’État, c’est-à-dire qu’il n’est pas question de privatiser, de confier, de déléguer au privé par exemple le fichier des empreintes génétiques, le fichier des empreintes…

Asma Mhalla : Les technologies aujourd’hui sont sous-traitées au privé. Quand on voit Alicem c’est, me semble-t-il, Gemalto2.

François Bersani : Vous parlez de l’informatique pure.

Asma Mhalla : Qui produit les logiciels ? C’est le secteur privé.

François Bersani : Oui, mais l’exploitation par les forces de sécurité est toujours faite par des humains comme moi ou comme d’autres et il n’y a pas… La main n’est pas…

Stéphanie De Muru : François Bersani vous êtes peut-être, on n’en doute pas une seule seconde d’ailleurs, quelqu’un pavé de bonnes intentions, honnête et loyal.

François Bersani : Il y a plein d’outils de traçabilité.

Stéphanie De Muru : Mais si ces outils se trouvent entre de mauvaises mains effectivement, entre des mains plus malveillantes, ça donne quoi ? C’est ça je pense.

François Bersani : Je vous assure que tous les fichiers qui sont utilisés par les forces de police ou de gendarmerie en France sont hyper-tracés. Toute connexion fait l’objet d’une traçabilité parce qu’on doit se connecter sur des portails sécurisés avec des codes, je ne donnerai pas plus d’informations. Toute action des forces de sécurité est toujours tracée. Même pour des demandes de vidéoprotection, des demandes d’information, il faut savoir qu’actuellement les fichiers ne sont pas tous connectés. On a toujours l’impression que la Sécurité sociale, les Allocations familiales, les impôts livrent en flux continu des informations aux services de sécurité, ça ne se passe pas comme ça malheureusement, ce serait le rêve !

Asma Mhalla : Pourtant on a voulu fliquer, on veut toujours fliquer les réseaux sociaux à des fins de contrôle fiscal me semble-t-il, c'est une des velléités…

François Bersani : Entre ce que veulent certains corps d’État et ce qui se fait, en tout cas dans la police que je connais bien depuis une vingtaine d’années, je peux dire qu’au niveau des enquêteurs on a soif d’avoir un instrument, un outil qui puisse nous aider, mais encore une fois ce ne sait qu’une aide à l’enquête. J’ai ouvert le débat pas ça, en disant c’est une aide à l’enquête, ce n’est pas l’alfa et l’oméga, c’est-à-dire que ça ne va pas faire l’enquête à la place du policier. Aujourd’hui l’identification d’auteurs de crimes ou de délits se fait quand même à 99 % par le cerveau puisque les policiers et les gendarmes de ce pays ont toujours un cerveau qui leur permet d’exploiter sans l’aide d’outils informatiques ou technologiques.

Stéphanie De Muru : Asma Mhalla, vous êtes rassurée là ?

Asma Mhalla : Je suis absolument persuadée de la bonne foi et de la volonté des policiers. Ce n’est pas du tout un procès d’intention à la police, absolument pas. La question c’est la question de quelle société on veut en réalité ? Donc c’est un débat qui est beaucoup plus large que « est-ce que les policiers font bien ou mal leur boulot ? » Je suis absolument persuadée qu’ils le font très bien.

Stéphanie De Muru : Ils peuvent bénéficier de cet outil.

Asma Mhalla : La question n’est pas là. La question est beaucoup plus large et nous dépasse. En réalité c’est collectivement : quelle société on veut construire sur quel nouveau système de valeurs ? La technologie induit ces questions-là : quelle définition on donne à la liberté, à la justice et plus généralement à nos valeurs ensemble ?

Stéphanie De Muru : Est-ce que ce n’est pas, de toute façon, inéluctable ?

Asma Mhalla : Pas forcément. Aujourd’hui l’Europe s’est positionnée comme le champion de l’éthique et de l’innovation, mais l’innovation ce n’est pas forcément l’innovation technologique, elle peut aussi être sur le terrain des libertés. Or aujourd’hui, on voit bien quand même que le terrain des libertés se rétrécit comme peau de chagrin. Donc qu’est-ce qu’on met face à ça ? Comment est-ce qu’on réinvente ces libertés-là ? Comment on réinvente nos droits dans cette nouvelle société ?

Stéphanie De Muru : La menace terroriste est un fait, tout de même, malheureusement.

Asma Mhalla : Elle est un fait, mais est-ce que fondamentalement on a vraiment réussi à éviter chaque attentat qui a eu lieu ? Non. En réalité la question de l’efficacité quand je vous ressors les études de Scotland Yard qui sont franchement pas probantes, la technologie a encore beaucoup de progrès à faire. Donc quels sont les dommages collatéraux qu’on va payer en attendant d’arriver à un taux de réussite de 100 % ?

Stéphanie De Muru : C’est vrai qu’avec François Bersani on disait que Londres est une des villes qui utilise le plus la reconnaissance faciale, il y a eu malheureusement beaucoup d’attentats dans la ville britannique.

François Bersani : Que ces outils anticipent la commission de crimes, de délits ou d’attentats, je pense que là, en effet, on est dans la littérature, la romance, la science-fiction ; James Bond a aussi beaucoup aidé en ça et certains films d’espionnage.

Par contre, pour partir à la traque ou à la chasse de terroristes ou de criminels qui sont en fuite, là c’est intéressant puisque la reconnaissance faciale permet dans le contrôle d’un flux massif de personnes de pouvoir essayer d’isoler et de suivre éventuellement. On parle souvent des moyens de transport, aéroports, gares et autres, et ce serait un outil technologique, mais toujours une aide à l’enquête avec toujours des policiers sur la souris pour suivre éventuellement des personnes en fuite, mais, bien sûr, avec des garanties. C’est-à-dire, aussi, que ça doit être réservé à une catégorie de crimes ou délits. On ne va pas s’amuser à faire ça pour tous les crimes et délits en France.

Stéphanie De Muru : Asma Mhalla rapidement.

Asma Mhalla : Mais aujourd’hui, dans ces cas spécifiques, la loi le permet déjà. Pourquoi est-ce qu’on veut généraliser quelque chose qui est déjà permis, un outil qui est déjà entre vos mains sur des cas spécifiques de recherche ciblée ? Ça, ça m’inquiète un tout petit peu. Ce qui amène encore l’argument de la surveillance généralisée : on est en train de créer progressivement des briques pour arriver à quelque chose qui potentiellement peut être dangereux et qui va au-delà de la volonté de la police. Ce n’est pas du tout la question.

Stéphanie De Muru : Merci Asma Mhalla et François Bersani de nous avoir apporté vos deux points de vue.